Natürliche und Künstliche Intelligenz. Das Zeitalter der Roboter hat begonnen.

Nicht jeder mag lange zuhören, weshalb ich mich entschlossen habe, Euch hier meinen Vortrag vom 6. 5.2022 auf seniorentreff.tv über "Natürliche und Künstliche Intelligenz. Das Zeitalter der Roboter hat begonnen" als Textversion aufzubereiten.

Download der PDF-Version des nachfolgenden Textes.

Einleitung

Liebe Gäste, liebe Freunde, liebe Seniorentreffler,

ich freue mich, dass ihr Interesse an meinem Thema habt. Künstliche Intelligenz wird m. E. das Leben der Menschen sehr stark verändern und hoffentlich verbessern.

Seit vielen Jahren beobachte ich die Entwicklung der Computer und der künstlichen Intelligenz. Meine Sichtweise ist hierbei die eines Neurobiologen, der die natürliche Intelligenz von Tieren und uns Menschen als die Leistung der Informationsverarbeitung in unserem Gehirn ansieht.

Ich bin mir bewusst, dass die Neurowissenschaften noch keinesfalls im Detail verstehen, wie die Verschaltung und Interaktion der etwa 86 Milliarden von Nervenzellen so etwas wie einen menschlichen Geist zustande bringen können, aber ich sehe wie die Informationswissenschaften die Neurowissenschaften durchdringen und umgekehrt biologische Gehirne und deren Funktionen zunehmend den Informatikern als Vorbild dienen.

Es gibt ein Zusammenfließen der Neuro- und Informationswissenschaften.

Angesichts dieser Entwicklungen habe ich mich schon Ende der 70iger und Anfang der 80iger Jahre in Seminaren und Aufsätzen gegen eine Verharmlosung der sich andeutenden digitalen Entwicklungstendenzen gewendet und betont, dass es wichtig sei, diese Entwicklung bewusst zu lenken und sich nicht treiben zu lassen.

Mehr als 40 Jahre später halte ich nun diesen Vortrag. Enormes hat sich innerhalb dieser kurzen Zeitspanne getan. Computer sind keine isolierten digitalen Wunderwerke mehr, sondern Knoten im Netz. Alles ist mit jedem verbunden und die Spielregeln haben sich komplett gewandelt.

Aber noch immer halten sich alte Vorurteile, die offenbar nicht auszurotten sind, und in der allgemeinen Vorstellung werden die Grenzen der Entwicklung mittels unhaltbarer Unmöglichkeitspostulate weiterhin viel zu eng gezogen.

Dabei werden die Grenzen für die Entwicklung der künstlichen Intelligenz allein durch die Naturgesetze bestimmt, die auch die Evolution der natürlichen Intelligenz ermöglicht haben.

Es ist kein Naturgesetz oder Gesetz der Logik bekannt, das speziell nur die Fähigkeiten künstlicher Gehirne beschränken würde. Eher ist es so, dass die Biologie unseren Gehirnen ihre Grenzen setzt. So ist z. B. der Temperaturbereich, in dem sie funktionieren können, klein und ihre theoretische Rechengeschwindigkeit ist aufgrund der Biochemie ihrer Bausteine begrenzt.

Es ist deshalb gefährlich, die Entwicklung der künstlichen oder maschinellen Intelligenz zu unterschätzen. Wir sollten aufhören, die Leistungen unserer Gehirne zu überschätzen und erkennen, dass die Entwicklung der künstlichen Intelligenz zwar erst am Anfang steht, aber uns schon heute bei vielen Aufgaben haushoch überlegen ist. Ich leugne die Vorteile nicht, die sich daraus ergeben und die auch ich nach Möglichkeit nutze, aber ich stelle die Frage: Was bleibt vom Menschen?

Warum ich mich für natürliche und künstliche Intelligenz interessiere

Bereits als Schüler habe ich mich für die biologische Evolution begeistert und z. B. das Buch „Der Mensch im Kosmos“ von Teilhard de Chardin verschlungen. Haften geblieben ist mir eine der Kernaussagen Teilhard de Chardins von der „Diskontinuität in der Kontinuität“. Was er damit meint ist Folgendes. Sehr lange Zeit ändert sich oft nur sehr wenig in der Zeiteinheit. Alles sieht stabil aus, aber dann plötzlich treten erstaunlich schnelle Zustandsänderungen auf, wenn z. B. irgendein Parameter einen kritischen Wert erreicht.

Einfachstes Beispiel ist das Erhitzen von Wasser. Lange Zeit geschieht nichts Dramatisches, aber plötzlich beginnt das Wasser zu kochen, weil es seinen Aggregatzustand ändert und zu Gas wird. Teilhard de Chardin veranschaulicht mit dieser Analogie das Entstehen des Geistes. Über Jahrmillionen sind die Gehirne der Tiere aufgrund der biologischen Gesetzmäßigkeit immer größer und komplexer geworden und dabei ist das, was wir „den Geist oder die Seele“ nennen herangereift, um dann bei der Menschwerdung zu „explodieren“.

Meine von Teilhard de Chardin und Konrad Lorenz inspirierte schulische Jahresabschlussarbeit über die Evolution des Menschen brachte mir ein Stipendium der Studienstiftung des deutschen Volkes ein, das mir das Studium der Biologie in Freiburg und der Biochemie in London ermöglichte. Gearbeitet habe ich zeitlebens neurobiologisch mit dem Schwerpunkt auf dem Gebiet der Gehirnentwicklung.

Ich habe bereits Mitte der 70iger Jahre am Lehrstuhl für Genetik in Würzburg bei Prof. Martin Heisenberg als Assistent ein Seminar zur Thematik „Natürliche und künstliche Intelligenz“ organisiert und weiß, dass dieses Seminar damals die berufliche Karriere einiger Studenten maßgeblich beeinflusst hat.

Mein Ziel war es durch den Vergleich der natürlichen Intelligenz mit der künstlichen Intelligenz verständlich zu machen, wie künstliche Intelligenz funktioniert und warum für mich die Entwicklung künstlicher Gehirne und künstlicher Intelligenz fast grenzenlose Entwicklungschancen bietet.

Selbstverständlich können auch künstliche Gehirne keine Aufgaben lösen, die grundsätzlich unlösbar sind, aber - wie ich schon sagte - es gibt kein Naturgesetz oder Gesetz der Logik, dass künstlichen Gehirnen Grenzen setzt, die für natürliche Gehirne nicht auch gelten würden.

Kurze Gliederung meines Vortrags

In meinem Vortrag heute Abend werde ich die Thematik beschränken müssen. Bei jedem Teilaspekt werde ich Vieles weg lassen und den Mut zur großen Lücke haben müssen, hoffe aber trotzdem ein zusammenhängendes Bild zeichnen zu können. Die Punkte, über die ich sprechen möchte, sind in der folgenden Folie aufgelistet. In der Diskussion werden wir dann viele offene Fragen besprechen können.

Warum sich die biologische und die kulturelle Evolution beschleunigen

Bei der Evolution intelligenter Maschinen sehe ich viele Parallelen zur biologischen Evolution, allerdings gibt es einen wesentlichen Unterschied - die ungeheure Geschwindigkeit, mit der die Entwicklung abläuft, so dass wir geneigt sind von einer Folge digitaler Revolutionen zu sprechen.

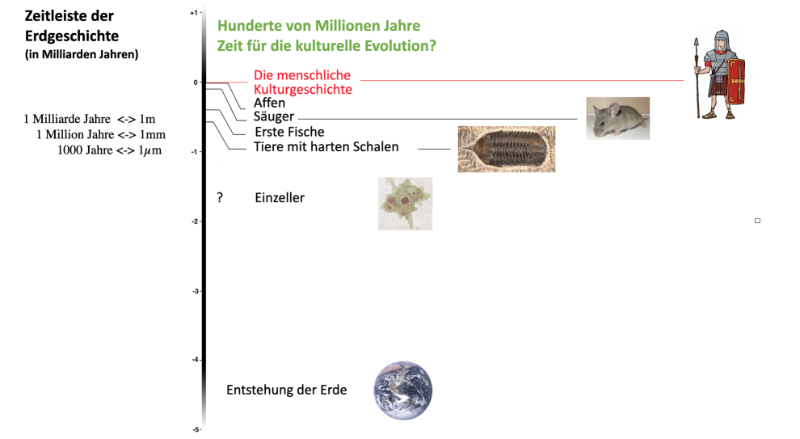

Schon die biologische Evolution hat sich im Laufe der Jahrmillionen deutlich beschleunigt. Wenn wir uns die Erdgeschichte anschauen, wird dies deutlich:

Verantwortlich für diese mehr als exponentielle Beschleunigung in der Evolution ist der modulare Aufbau der Organismen. Jede neue Stufe in der Evolution ermöglicht die nächst höhere. Darüber könnte ich viele Vorlesungen halten, aber heute möchte ich das einfach einmal so stehen lassen.

Die Ursache für diese Beschleunigung in der biologischen Evolution findet ihre Entsprechung auch in der Evolution von Maschinen.

Jede hilfreiche Maschine beschleunigt die Entwicklung noch hilfreicherer Maschinen. Im Englischen ist dieses Prinzip als „The law of accelerating returns“ bekannt geworden, die deutsche Übersetzung wäre „Das Gesetz der sich beschleunigenden Rendite“. Ray Kurzweil hat dieses „Gesetz“ in seinem Buch „The singularity is near“ (auf Deutsch: Menschheit 2.0. Die Singularität naht) mit eindrucksvollen Beispielen belegt.

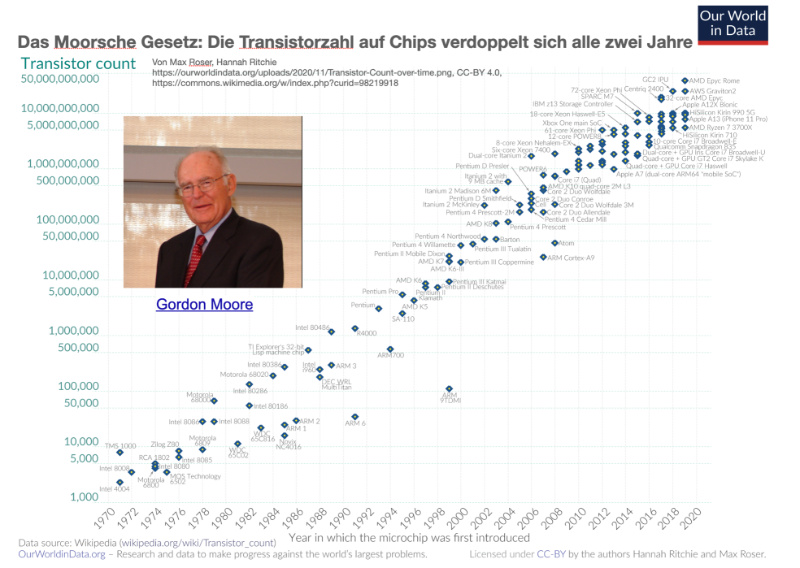

Dieses „Gesetz“ schlägt sich auch in dem bereits 1965 von dem Intelgründer Gordon Moore formulierten und nach ihm benannten „Gesetz“, dem Moorschen „Gesetz“ nieder, dass sich die Anzahl der Schaltelemente auf Microchips alle zwei Jahre verdoppelt. Die Dichte der Schaltelemente in den Microchips geht Hand in Hand mit der Leistungsfähigkeit der Elektronengehirne.

Wir haben es hier mit einer logarithmischen Skala zu tun. In einer solchen Skala bedeutet eine Gerade exponentielles Wachstum.

Wie schwierig wir Menschen uns mit exponentiellem Wachstum tun, das hat uns die Corona-Krise gelehrt. Viele konnten sich nicht vorstellen, wie schnell sich eine Pandemie ausbreitet, in der jeder neu Erkrankte mehrere andere anstecken kann.

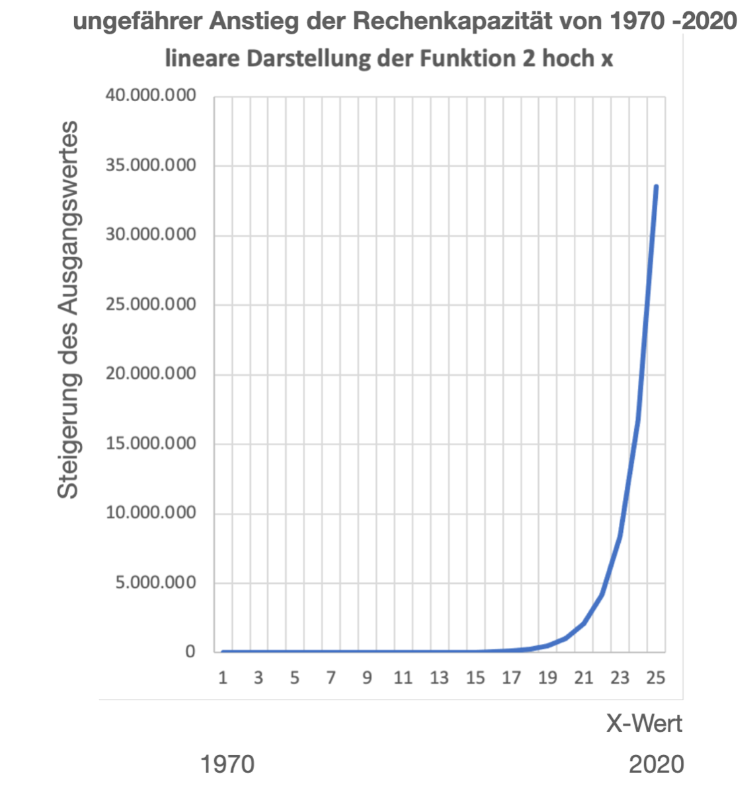

Es ist klar, dass ein exponentielles Wachstum eines Parameters wie die Zahl der Schaltelemente auf Mikrochips bei Verdopplung alle zwei Jahre über einen Zeitraum von 50 Jahren zu einer dramatischen Entwicklung der „Rendite“ führen kann, es ist immerhin ein Wachstum um das 2 hoch 25fache, das über 33 Millionenfache des Ausgangswertes!! Solch eine Funktion stellt sich linear anschaulich ganz anders dar als logarithmisch und macht deutlich, was exponentielles Wachstum bedeutet.

Das erinnert doch stark an das Erwärmen von Wasser bis zu einem bestimmten Schwellenwert. Lange Zeit tut sich praktisch nichts, bis dass dann plötzlich eine Änderung des Aggregatzustandes stattfindet.

Die Entwicklung von intelligenten Maschinen jedenfalls hat durch den enormen Fortschritt der Technologie eine sprunghafte Beschleunigung erfahren und diese Entwicklung ist auch noch nicht beendet. Wir dürfen gespannt sein, was für Entwicklungssprünge uns noch Quantencomputer, die derzeit in der Entwicklung sind, bringen werden.

Wir leben in einer spannenden Zeit, in der die Welt aus den Fugen zu geraten droht. Es scheint vermessen sich mit dem akademischen Thema „Natürliche und künstliche Intelligenz“ in einer Zeit zu beschäftigen, in der die Menschheit wieder einmal daran arbeitet, sich in die Steinzeit zurück zu bomben.

M. E. ist es aber gerade jetzt, wo es an ihr mangelt, an der Zeit zu fragen

„Was ist Intelligenz überhaupt und wozu ist sie gut?“

1979 habe ich einen Aufsatz geschrieben, dessen Zusammenfassung wie folgt lautete: Intelligenz hat sich in der natürlichen Evolution herausgebildet, weil sie eine Hilfe im Überlebenskampf ist. Wir verbinden den Begriff der Intelligenz eng mit der Fähigkeit kluge Entscheidungen in Bezug auf zukünftige Entwicklungen zu treffen.

Intelligenz hat sich in der natürlichen Evolution herausgebildet, weil sie eine Hilfe im Überlebenskampf ist. Wir verbinden den Begriff der Intelligenz eng mit der Fähigkeit kluge Entscheidungen in Bezug auf zukünftige Entwicklungen zu treffen.

Wir verknüpfen Intelligenz eng mit der Fähigkeit zu lernen. Diese Fähigkeit wurde in der Evolution der Tiere durch die Ausbildung von immer komplexeren Gehirnen zur Perfektion gebracht. Eine wichtige vorprogrammierte Fähigkeit von Gehirnen ist es, lernen und dadurch zukünftige Ereignisse immer besser voraussehen zu können.

Lernverhalten findet instinktiv, automatisch statt, wir können Lernen nicht vermeiden. Gehirne sind Lernmaschinen und dieses Lernvermögen ist tief in der Biologie der Gehirne, in deren neuronalen Netzen verankert.

Nehmen wir ein neugeborenes Baby als Beispiel. Einige überlebenswichtige Verhaltensweisen sind fest einprogrammiert, dazu gehört das Atmen, der Saug- und der Greifreflex, ja sogar das Lächeln. Der Säugling muss jedoch sehr viel Neues lernen. Dazu ist sein Gehirn hervorragend ausgestattet. Im Laufe der Zeit lernt er z. B. Gesichter zu unterscheiden und die Sprache seiner Eltern zu verstehen und zu sprechen. Er lernt seine Welt kennen und findet sich mehr und mehr in ihr zurecht. Die Lernmechanismen, die dabei zum Einsatz kommen sind vielfältig.

Persönlich erinnere ich mich vieler „Lern-Episoden“ mit meinem Sohn. Ich erinnere z. B. seine Freude, als er entdeckte, dass das Betätigen des Lichtschalters Licht-an und Licht-aus bedeuten kann. Nicht einmal, nein 10 bis 20 mal probierte er es sofort hintereinander aus.

In der Fachsprache heißt dies „operantes assoziatives Lernen“, der Organismus erfährt Rückmeldungen auf sein Verhalten, die dieses Verhalten fördern oder hemmen können. Gelernt wird eine Wenn - Dann Beziehung. Seit dem Lernprozess weiß mein Sohn für immer, dass man mit einem Lichtschalter Licht ein- und ausschalten kann.

Vielen wird auch der Begriff der „klassischen Konditionierung“ bekannt sein. Das Beispiel hierfür ist das Experiment des russischen Physiologen Iwan Petrowitsch Pawlow mit einem Hund. Vor der Fütterung ließ er immer eine Glocke ertönen und stellte fest, dass der Hund schon sehr bald allein auf das Signal der Glocke zu sabbern begann, weil er auf das Futter wartete.

Generell gilt, dass wir darauf programmiert sind, Reize, die wiederholt vor einem Ereignis stattfinden, beginnen als Ursache für dieses Ereignis zu begreifen. Ein Blitz führt immer zu einem Donner. Wir bauen uns auf diese Weise allmählich ein kausales Bild der Welt auf. Wir werden durch dieses Lernen in die Lage versetzt, der Zeit ein wenig voraus zu sein. Sobald wir eine gelernte Ursache für ein Ereignis erkennen, können wir uns auf dieses Ereignis vorbereiten.

Diese Lernreflexe, die wir nicht vermeiden können, können uns aber auch in die Irre führen. Der Fussballtrainer, der viele Spiele mit seiner Mannschaft gewonnen hat, während er einen grünen Schal trug, schwört nun auf diesen grünen Schal als seinen Talisman. D. h. Korrelation kann eine kausale Verknüpfung vortäuschen. Wir müssen also immer bedenken, dass Lernmechanismen grundsätzlich fehlerbehaftet sind, das gilt auch wenn wir uns später mit maschinellem Lernen beschäftigen.

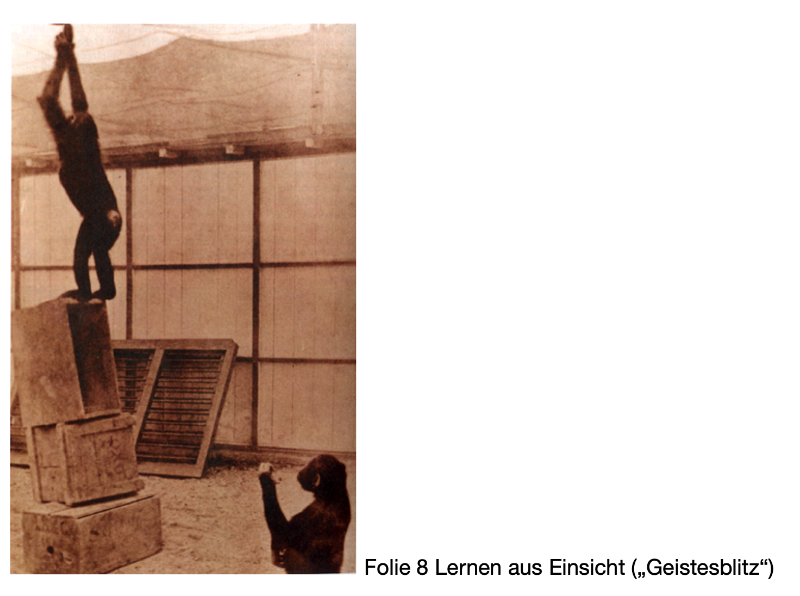

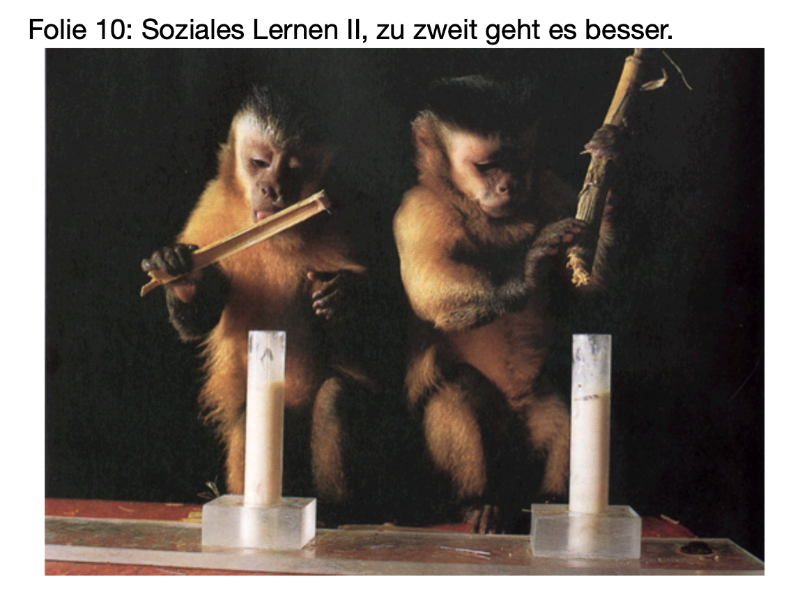

Tierische und menschliche Organismen verfügen aber über noch mächtigere Lernmechanismen als über operante und klassische Konditionierung, z. B. über Lernen aus Einsicht und „soziales Lernen“ durch Nachahmung.

Lernen aus Einsicht erfordert, dass sich die Gehirne ein Modell der Welt aufgebaut haben, in der sie die Handlungen ihrer Körper durchspielen können.

Dass Durchspielen von Handlungsfolgen „im Kopf“, in einem Modell von der Welt hat einen enormen Überlebensvorteil. Man muss nicht in den Abgrund springen, um zu wissen, dass man sich die Knochen brechen würde.

Im vorliegenden Experiment z. B. waren die Schimpansen vor die Aufgabe gestellt worden, eine an der Raumdecke befestigte Banane zu pflücken. Die Banane hing zu hoch, um sie durch einen Sprung zu erreichen, was die Affen sichtlich frustrierte.

Im Raum befanden sich auch einige vom Experimentator zufällig verstreute Holzkisten. Plötzlich stürmte einer der Schimpansen los, stapelte die Kisten aufeinander und pflückte sich die Banane. Er hatte ganz offensichtlich einen „Geistesblitz“ gehabt. Er hatte sich im Kopf diese Lösung durchgespielt und „kapiert“, dass er so sein Ziel erreichen würde.

Der zweite Schimpanse schaute interessiert zu und würde es beim nächsten Mal wohl ebenso machen.

Lernen durch Nachahmung ist eine Form des sozialen Lernens. Diese Lernform ist bei vielen Tierarten beobachtet worden und beim Menschen durch die Schule instutionalisiert worden.

Wir werden sehen, dass gemeinschaftliches Lernen auf maschinellem Niveau noch einmal eine ganz andere Qualität gewinnen kann. Doch zunächst möchte ich die Frage stellen:

Was passiert beim Lernen im Gehirn?

Gehirne haben sich primär entwickelt, um die Informationen der besonders am Kopf platzierten Sinnesorgane zu verarbeiten. Lichtrezeptoren, Geruchs- und Geschmackssensillen, akustische Sinneshärchen sowie Tastsensillen (Schnurrbarthaare) senden ihre Informationen in separate Gehirnareale, wo sie in mehreren Neuronenschichten, die miteinander intensiv vernetzt sind, ausgewertet werden.

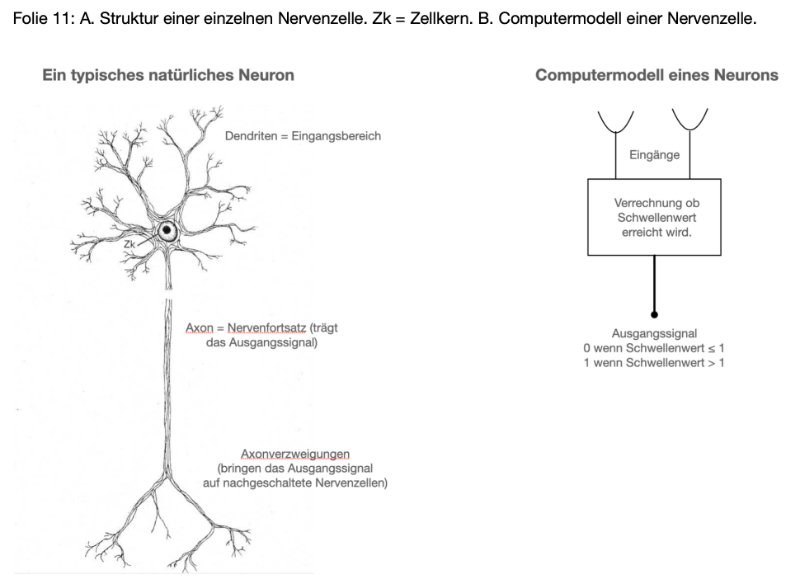

Es ist hier nicht der Ort, um ausführlich auf Gehirnanatomie einzugehen, aber ich möchte doch die Struktur des Grundelementes erwähnen, die Struktur einer einzelnen Nervenzelle, auch Neuron genannt, denn nur dann verstehen wir auch, was unter einem neuronalen Netz zu verstehen ist und was Lernprozesse in einem solchen Netz verändern.

Wichtig zum Verständnis der Funktionsweise von Nervenzellen ist es, dass sie normalerweise sehr viele Eingangskanäle besitzen, aber nur einen Ausgang, der seinen Wert jedoch an sehr viele nachgeschaltete Nervenzellen weitergeben kann.

Schon 1943 wurden von Warren McCulloch und Walter Pitts künstliche Nervenzellen vorgeschlagen und sie zeigten an ihren Modellen, dass diese einfache logische Funktionen ausführen konnten, z. B. logische UND oder ODER-Funktionen.

Ein Neuron kommt nun nicht allein. In unserem Gehirn gibt es etwa 86 Milliarden davon, 86.000.000.000, etwa 10 mal so viele wie es derzeit Menschen auf der Erde gibt. Nervenzellen können nur im Verbund die Leistungen unseres Gehirns erklären. Auch Lernen erfordert mehr als eine Nervenzelle.

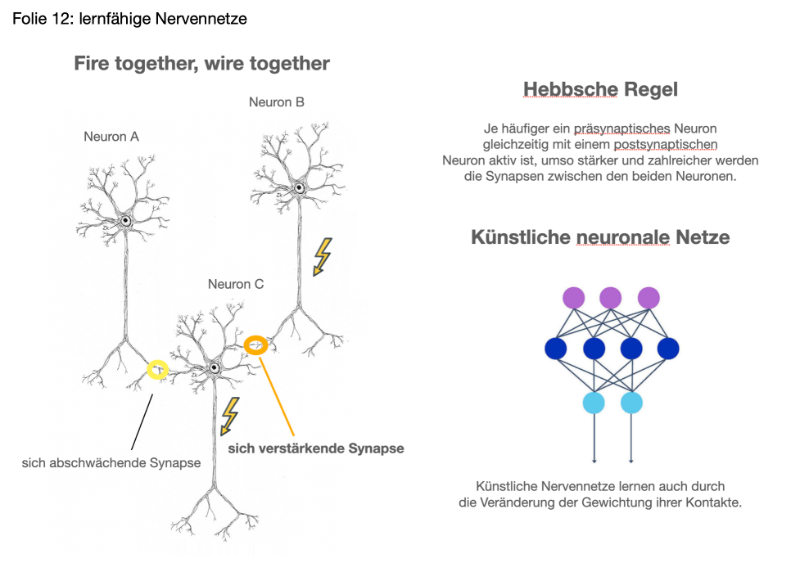

Schauen wir uns also folgende drei Nervenzellen an. Die Verbindungen zwischen den Neuronen werden durch die Synapsen, die Kontaktstellen gebildet. Zwei von ihnen (Neuron A und B) sind dem Neuron C vorgeschaltet, man sagt auch, sie sind präsynaptisch (vor der Synapse). Neuron C ist dann postsynaptisch (nach der Synapse). Ich gehe hier nicht auf die Biologie der Synapsen ein, die recht komplex ist.

Wichtig ist hier, dass Neuron C nicht nur Eingänge von den beiden gezeigten Neuronen erhält. Auch die anderen Dendriten machen Synapsen mit in der Regel vielen Tausenden von anderen präsynaptischen Nervenzellen. Hätte ich diese auch eingezeichnet, wäre nichts mehr zu erkennen gewesen.

Der Lernmechanismus, der automatisch auf der zellulären Basis abläuft, wurde von Donald O. Hebb 1949 in seinem Buch „Die Organisation des Verhaltens“ postuliert und zwischenzeitlich vielfach bestätigt:

Hebbsche Regel: Je häufiger ein präsynaptisches Neuron gleichzeitig mit einem postsynaptischen Neuron aktiv ist, umso stärker und zahlreicher werden die Synapsen zwischen den beiden Neuronen. Synapsen zu nicht synchron aktiven Neuronen werden schwächer.

Wenn wir lernen, tut sich also viel in unserem Kopf. Bei den Berufs-Taxifahrer von London hat man sogar festgestellt, dass sich die Größe bestimmter am Lernen beteiligter Gehirnareale, die Hippocampi vergrößern, wenn sie den Londoner Stadtplan mit über 25.000 Straßen und 20.000 Sehenswürdigkeiten auswendig lernen müssen.

Die Frage ist jetzt, kann man auch künstliche Neurone zu lernfähigen Nervennetzen zusammenschalten?

Lernen in Künstlichen Neuronalen Netzen (KNN)

Die Antwort ist, ja, man kann. Auch bei Künstlichen Neuronalen Netzen (KNN) kann die Hebbsche Lernregel fest vorgegeben und erfolgreich angewendet werden.

Ich möchte heute Abend das Prinzip deutlich machen, wie sehr die Computerwissenschaften von ihren biologischen Vorbildern gelernt haben, ohne zu sehr in die Finessen der Konstruktion heutiger künstlicher neuronaler Netze einzutauchen, von denen es inzwischen sehr viele Architekturen gibt, die sich in ihrer Leistungsfähigkeit unterscheiden und die auch Besonderheiten aufweisen.

Hinweisen möchte ich aber darauf, dass künstliche Intelligenz zwar bereits sehr früh von einigen Forschern mit neuronalen Netzen verknüpft wurde, aber die ersten Erfolge mit alternativen logischen Schaltkreisen errungen wurden.

Die Computer feierten erste Erfolge, weil sie auf Gebieten gut waren, z. B. bei der Mathematik und bei Problemen der Logik, bei denen sich Menschen teilweise extrem schwer tun. Interessanterweise versagten die Computer in ihrer Anfangszeit jedoch kläglich bei Problemen, die dem Menschen intuitiv leicht fallen, wie Gesichtserkennung und Sprachenlernen.

1958 fand das Perzeptron genannte KNN von Frank Rosenblatt zwar Aufmerksamkeit, aber die mangelhafte Rechenleistung der Computer, auf denen solche rudimentären Netze digital simuliert wurden, limitierte die Anzahl der künstlichen Nervenzellen sehr stark. Es konnte dann 1969 durch Marvin Minsky und Seymour Papert auch gezeigt werden, dass das konkret vorgeschlagene Perzeptron Rosenblatts einige Aufgaben nicht lösen konnte und fälschlicherweise vermuteten die Autoren hier sogar ein prinzipielles Problem der neuronalen Netze, weshalb die Forschungsgelder für neuronale Netze zeitweise komplett eingefroren wurden und fast 15 Jahre lang wenig an ihnen geforscht wurde.

Erst die exponentielle Entwicklung der Rechenleistung moderner Computer (es sei an das Moorsche Gesetz erinnert) hat in diesem Jahrtausend zu einer fulminanten Wiederbelebung neuronaler Netze geführt, in denen mehr und mehr künstliche Neuronen implementiert werden können. Parallel hierzu verläuft die Erfolgsgeschichte dessen, was neuronale Netze zu leisten im Stande sind.

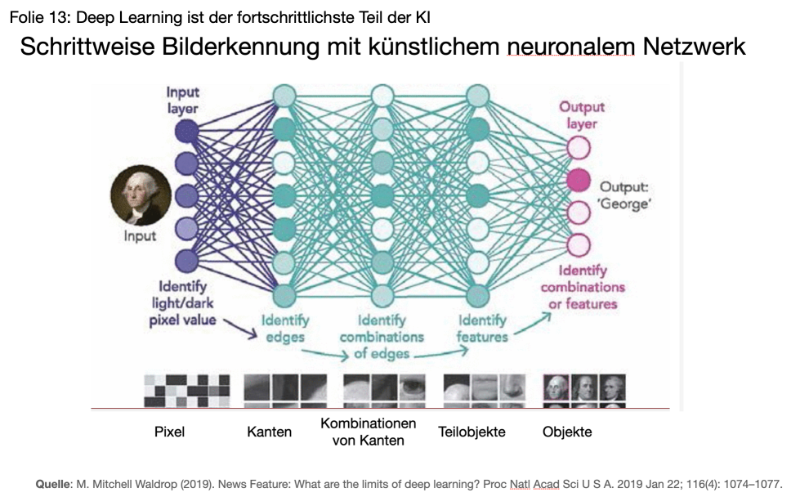

Als Stichwort möchte ich sogenannte convoluted neural networks erwähnen, bei denen die einzelnen inneren Schichten funktionell spezialisiert sind und bei denen nicht in allen Schichten jedes Neuron mit jedem anderen verknüpft sein muss. Diese CNN, wie sie abgekürzt genannt werden, können erstaunliche Dinge leisten, z. B. ortsunabhängig ein Objekt erkennen. Auch für uns ist es ja für die Objekterkennung unerheblich, ob sich ein Objekt links unten oder rechts oben im Gesichtsfeld befindet. Wir werden so z. B. eine Katze im Gesichtsfeld überall erkennen und von einer Tasse unterscheiden können.

Diese CNN können auch das durchführen, was inzwischen selbständiges Deep Learning genannt wird (Lernen ohne Anleitung durch den Menschen)

Das faszinierende an dieser Methode der Bilderkennung ist, dass sie quasi die 1958 publizierten Ergebnisse von Hubel und Wiesel an biologischen Gehirnen nachbaut, für die diese 1981 den Nobelpreis für Medizin erhielten.

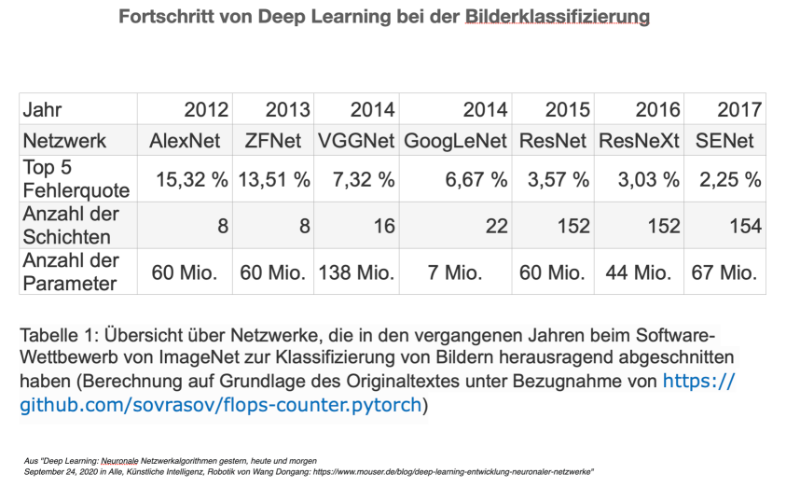

Die visuelle Bilderkennung durch Deep Learning machte seit 2012 gewaltige Fortschritte, dies ist auch in der folgenden Tabelle abzulesen, die die Ergebnisse des 2017 beendeten Wettbewerbs der verschiedenen Anbieterfirmen zeigt. Die Aufgabe bestand darin, die Bilder der riesigen Bilddatenbank ImageNet in sinnvolle Kategorien einzuordnen und zu beschriften. Die menschliche Fehlerquote soll bei 5% liegen.

Den letzten Punkt möchte ich mit Googles Duplex illustrieren. Dieses System wurde vor 3 Jahren von Googles CEO Sundar Pichai vorgestellt.

Der Google Software-Assistent kann selbstständig z. B. ein Restaurant anrufen und eine Reservierung vornehmen. Im vorliegenden Fall ist dies die männliche Stimme, die beauftragt war einen Tisch für 4 Personen zu bestellen. Es stellt sich im Gespräch heraus, dass eine Reservierung unnötig ist, da zur angegebenen Zeit Platz genug da sein wird.

Vorbei sind also die Zeiten blechener oder unflexibel eintöniger Roboterstimmen. Damit wird es aber noch schwieriger im Internet Fake von Wahrheit zu unterscheiden. Neuronale Netze sind nämlich inzwischen auch fähig, selber Bilder zu generieren und können benutzt werden, um Menschen Worte in den Mund zu legen, die sie nie gesagt haben.

Bestürzendes Beispiel hierfür ist der ukrainische Präsident Selenskyj, dem Hacker in einem deep fake Video die Kapitulation der ukrainischen Streitkräfte in den Mund legten.

Das Zeitalter der Roboter hat begonnen

Es wäre einfach, stundenlang über die bisherigen Erfolge und Anwendungen von Deep Learning Methoden zu sprechen. Dann würden wir aber den im Titel meines Vortrags erwähnten Unterpunkt „Das Zeitalter der Roboter hat begonnen“ verpassen.

Bisher haben wir über die Leistung von Elektronengehirnen geredet, die meist in stationären Kästen lokalisiert sind und ihre Daten zum Verarbeiten von Menschen vorgesetzt bekommen. Was aber, wenn die Elektronengehirne selbst in die Welt hinausgehen und dort beginnen ihre eigenen Erfahrungen zu sammeln? Hatten wir zu Beginn nicht erwähnt, dass sich biologische Gehirne in beweglichen Tieren gebildet haben und Begriffe wie „Vorsicht“, „Vorausschau“ etc. eng mit deren Vorwärtsbewegung verknüpft sind?

Wenn wir jetzt über Roboter sprechen, dann möchte ich betonen, dass deren Unterschiedlichkeit enorm ist. Sie haben viele Väter, benutzen völlig unterschiedliche Techniken und sind (bisher von Menschen) zu ganz unterschiedlichen Zwecken konstruiert worden.

Z. B. zu

Industrieroboter

Über Industrieroboter möchte ich hier nicht viel erzählen, obwohl sie enorme Leistungen vollbringen und ihr Effekt, die Wegrationalisierung menschlicher Arbeitskräfte kaum weg zu argumentieren ist.

Selbstfahrende Autos

Ich möchte heute lieber zunächst über rollende Roboter sprechen, über selbstfahrende Autos, weil sich daran bereits heute wesentliche Prinzipien erläutern lassen, die die Welt verändern werden.

Wir alle wissen, dass Tesla seit Jahren versprochen hat, seine Autos mit Full Self Driving (FSD) Software für autonomes Fahren auszustatten, dass sich dies zwar noch verzögert, aber kaum jemand zweifelt wirklich daran, dass sehr bald autonome Fahrzeuge vieler Hersteller unsere Straßen bevölkern werden. Tatsächlich sind die bei Youtube für jeden einsehbare Videos sehr beeindruckend.

Es sind in der Tat riesige Fortschritte gemacht worden und u. a. Google und Tesla sind bereits auf Californischen Straßen im FSD-Modus unterwegs. Aber die Sensoren aller Tesla-Autos weltweit, auch die nicht autonom fahrenden, und dies sind inzwischen Millionen, sammeln Daten für die große zentrale Tesla-KI, auf der alle Daten zentral zum Lernen von sicherem Fahren und zur Erstellung von Straßenkarten ausgewertet werden. Die Ergebnisse kommen beim nächsten Software-Update über das Internet allen Teslafahrern zugute. Das ist „soziales Lernen“ auf höchstem Niveau.

Für den Tesla Chef Elon Musk sind die Autos langfristig aber offenbar gar nicht der letzte Schrei. Er hat jetzt angekündigt, dass die Software, die für das autonome Fahren entwickelt wird, auch das Rückrat für die Entwicklung autonomer humanoider Roboter sein wird. Er sieht die Produktion solcher Roboter langfristig als ein noch größeres Geschäft an als die Autos. Die Zahl von Privatautos wird aller Voraussicht nach abnehmen, aber der Besitz eines Privatroboters wird wahrscheinlich das Auto als neues Statussymbol ersetzen.

Fassen wir das zusammen. Rollende oder laufende Roboter sind nie alleine. Das Lernen künstlicher Gehirne läuft vernetzt ab, d. h., die Erfahrungen, die ein individuelles Gehirn sammelt, werden zentral verarbeitet und allen anderen blitzschnell zur Verfügung gestellt. Wir verstehen also, warum Elon Musk sich nun die Entwicklung des humanoiden Roboters Optimus zur Hauptaufgabe gemacht hat.

Warum humanoide Roboter?

Humanoide Roboter

Humanoide Roboter werden, soll es nach dem Willen der Entwickler gehen, schon bald Teil unseres Alltags sein. Sie werden alle Einrichtungen, die für Menschen konstruiert wurden, mit benutzen können und zunächst die Rolle von Arbeitern, Gehilfen und Altenpflegern einnehmen. Mit den folgenden Videos möchte ich einen Eindruck davon vermitteln, was auf uns zukommt, wenn Deep Learning Fähigkeiten, menschliche Mimik und perfekte Körperbeherrschung in Maschinen kombiniert werden.

Sophia wurde 2017 die Staatsbürgerschaft von Saudi Arabien übertragen.

Atlas ist ein humanoider Roboter von Boston Dynamics, einer Firma die einmal Google gehörte und nun an die japanische Softbank Group verkauft wurde. Boston Dynamics hat auch Forschungsgelder von Rüstungsunternehmen und von dem US-amerikanischen Militär erhalten. Man darf also nicht nur Gutes von dieser Entwicklung erwarten.

Zu bedenken ist, dass solche Roboter nicht nur ihre on-board Intelligenz besitzen werden, sondern miteinander eng vernetzt Informationen in Windeseile austauschen können. Was wenn das exponentielle Wachstum der Leistungsfähigkeit zu so etwas führt, was

Superintelligenz

genannt wird?

Geschrieben hat das der schwedische Philosoph Nick Bostrom. Es steht auf der Rückseite seines Buches „Superintelligenz“.

Nick Bostrom geht in seinem Buch konsequent den Weg weiter, den ich mit meiner Aussage, es gebe kein Naturgesetz, das die Entwicklung Künstlicher Intelligenz mehr einenge als unsere eigene, vorgezeichnet habe.

Er geht bei einer Fortsetzung des Moorschen Gesetzes davon aus, dass uns KIs sehr bald haushoch in allem überlegen sein werden und er betont dabei den positiven Rückkopplungseffekt, der die Entwicklung rasant beschleunigen würde, so dass wir von einer Intelligenzexplosion sprechen müssten.

Eine Superintelligenz könnte sich selbst optimieren und ihren eigenen Programmiercode umschreiben. Sie könnte dies, da superintelligent, sehr viel besser und schneller als jedes menschliche Team.

Deshalb, so argumentiert Nick Bostrom würde es auch nur eine Superintelligenz geben, denn einmal da, würde sie sehr schnell alle lohnenden Nischen besetzen und für ihre Ziele beanspruchen. Bostrom erinnert daran, dass wir Menschen die Erde nicht deshalb beherrschen, weil wir optimal angepasst seien, sondern weil wir als erste da gewesen seien. Keine Spezies würde neben uns noch einmal die Chance bekommen, unseren Level zu erklimmen. Ähnlich argumentiert er mit der Superintelligenz.

Das ganze Buch von 475 klein bedruckten Seiten beschäftigt sich deshalb mit der Frage, ob und wie wir Menschen Vorsorge treffen können, dass die Superintelligenz auch die richtigen Ziele haben wird und ob sie uns Menschen damit nutzen kann. Das ist teilweise sehr technisch zu lesen und es würde zu referieren auch keinen Spass machen.

Aber ein groteskes Beispiel von Bostrom sei hier genannt. Was wenn die KI, die zuerst den superintelligenten Status gewönne, als ursprüngliches Ziel haben würde, die Produktion von Büroklammern zu optimieren. Würde sie alles auf der Erde und auf den erreichbaren Planeten so einrichten, dass sie die Zahl der Büroklammerproduktion optimiert? Wie können solche absurden Ziele verhindert werden?

Der israelische Historiker Yuval Noah Harari, der Autor des wunderbaren Buches „Eine kleine Geschichte der Menschheit“ zeichnet ein etwas anderes, aber ebenso düsteres Bild unserer Zukunft. In seinem Werk „Homo deus“ sieht er unser humanistisches Weltbild, das das Individuum als das Maß aller Dinge ansieht, in Gefahr.

In seinem Kapitel, die große Entkopplung, beschreibt er, warum er überzeugt ist, dass der einzelne Mensch im globalen Handeln an Wert verlieren wird. Das System wird die Menschen als Kollektiv zwar weiterhin wertschätzen, aber es wird wahrscheinlich eine neue Elite optimierter Übermenschen möglich werden, die die Macht an sich reißen.

„Manche Ökonomen sagen voraus, dass nicht-optimierte Menschen früher oder später völlig nutzlos sein werden“ (Seite 422 in Homo deus).

Harari endet mit drei Schlüsselfragen, die wir auch verwenden können, um unsere Diskussion zu eröffnen:

- „Sind Organismen wirklich nur Algorithmen, und ist Leben wirklich nur Datenverarbeitung?

- Was ist wertvoller - Intelligenz oder Bewusstsein?

- Was wird aus unserer Gesellschaft, unserer Politik und unserem Alltagsleben, wenn nicht bewusste, aber hochintelligente Algorithmen uns besser kennen als wir uns selbst?“

Wird eine Superintelligenz kein Bewusstsein haben?

Empfohlene Literatur

de Chardin, Teilhard (1959): Der Mensch im Kosmos. Verlag C.H. Beck München.

Fischbach K.F.: "Mensch und Computer" in UMSCHAU 81 (1981) 11, 331-333

Hebb, Donald O. (1949): The organization of behavior. A neuropsychological theory. Erlbaum Books, Mahwah, N.J. 2002, ISBN 0-8058-4300-0 (Nachdruck der Ausgabe New York 1949)

Köhler, Wolfgang (1963). Intelligenzprüfungen am Menschenaffen. Berlin, Göttingen, Heidelberg: Springer. [S. 91 f]

Krause M. und G.F. Schaudt: "Computer Lyrik. Poesie aus dem Elektronenrechner". Droste Verlag. Düsseldorf 1967.

Kriesel, David (2005): Ein kleiner Überblick über Neuronale Netze. Downloadadresse: http://www.dkriesel.com/science/neural_networks

Kurzweil Ray (2005): „The Singularity is near“. Penguin Books. New York.

Minsky M. L. und Papert S. A. (1988), Perceptrons. 2nd Edition, MIT-Press, ISBN 0-262-63111-3

Rosenblatt, Frank (1958): The perceptron: a probabilistic model for information storage and organization in the brain. Psychological Reviews 65 (1958) 386–408

Samuel A.L. (1963): "Some Studies in Machine Learning Using the Game of Checkers". In "Computers and Thought", ed. E. Feigenbaum und J. Feldman, McGraw Hill New York (1963) pp.71-105

Turing A.M. (1936): "On computable numbers, with an application to the Entscheidungsproblem". Proc. of the London Mathematics Society (Series 2) 42, 230-265

Turing A.M. (1963): "Computing machinery and intelligence". Mind, October, 1950, 59, 433-460. Nachdruck in "Computer and Thought" Ed. E.A. Feigenbaum und J. Feldman. McGraw-Hill.

Wang Dongang (2020) Deep Learning: „Neuronale Netzwerkalgorithmen gestern, heute und morgen“ in Alle, Künstliche Intelligenz, Robotik https://www.mouser.de/blog/deep-learning-entwicklung-neuronaler-netzwerke

Weizenbaum, J (1976): "Computer Power and Human Reason". Freeman & Co., San Francisco.

Willwacher, Gerd (1976): Fähigkeiten eines assoziativen Speichersystems im Vergleich zu Gehirnfunktionen. Biol. Cybernetics 24, 181-198.

Mein Vortrag auf Youtube inklusive der nachfolgenden Diskussion

Ihr könnt zu den Kapiteln im Video springen

10:56 Warum beschleunigen sich die biologische und kulturelle Evolution?

21:23 Was ist Intelligenz überhaupt?

32:26 Was passiert beim Lernen im Gehirn?

41:45 Wie lernen Künstliche Neuronale Netze?

53:07 Deep Learning, Deep Art, Deep Dream, Deep Fake

1:05:50 Das Zeitalter der Roboter hat begonnen

1:17:40 Superintelligenz

1:23:43 Diskussion

Karl

Kommentare (5)

Herzlichen Dank an alle, die sich durchgearbeitet haben.

Ich habe hier jetzt auch das PDF meines Textes zum Download (und Ausdruck) verlinkt.

Karl

@Karl

Schwere Kost, nicht gerade einfach zu lesen und zu verstehen. Vielleicht liegt es ja daran, dass sich mir bei aller Faszination auch ein nicht gerade euphorisches Gefühl aufdrängt, was mich fragen lässt: Quo vadis, KI-bestimmter Homo sapiens?

Gerade in der Jahreszeit der langen Abende ist die Textversion zu diesem nicht gerade einfachen Thema willkommen, kann man sich doch mit einzelnen Passagen detailliert (und wiederholt) beschäftigen. Gut auch, die Videoversion dann auch noch aufrufen zu können.

Danke für das Einstellen sagt mit abendlichen Grüßen zum 4. Advent

Syrdal

Lieber Karl,

danke für die Textversion, die ich gerade mit Interesse kurz überflogen habe.

Aus Erfahrung denke ich, dass ich zu den „Lese-Lerntypen“ gehöre, und mir deshalb auf dieser Basis Informationen auch verständlicher und einprägsamer erscheinen.

Deshalb werde ich mir Deinen Text, jetzt natürlich nicht hektisch, sondern etwas später in aller Ruhe durchlesen.👍

Herzliche Grüße

Rosi65

So, lieber Karl, auch ich sage als erstes Danke!!

Habe mir alles angesehen und durchgelesen.

Finde es hochspannend. Kann ich nicht anderes sagen.

Es fasziniert mich, es begeistert mich.

Wollte ja ursprünglich Maschinenbau, E-Technik und die neu aufkommende

Informatik studieren, wäre als Frau damals aber in der BRD so nicht möglich

gewesen, aber die Begeisterung ist geblieben!!

Die Gefahren, die du benennst, also, es ist nicht so, dass ich sie nicht

verstehe, so ist es nicht, es ist eher, dass ich sie beiseite schiebe.

Oben fragst du, ob Leben nur " Datenverarbeitung " ist.

Ich sage da: Nein!

Dieses nein kommt meinerseits aus der Philosophie, vielleicht auch etwas

aus der Physik.( Quantenphysik) Wir wissen nicht in Gänze, was Leben ist. Wir können es unterschiedlich definieren.

Klar können wir sagen, Leben ist nix anderes als Datenverarbeitung.

Aber genau so richtig ist es, wenn wir sagen, es ist alles nur ein Schein und kein

Sein oder im Zen-Buddhismus: Der Finger, der auf den Mond zeigt, ist nicht der Mond selber.

Was nun " wertvoller " ist die Intelligenz oder das Bewußt-Sein, stellt mich vor die selbe Frage. Intelligenz wird definiert und Bewußtsein auch.

Also die Definition ist besagter Finger, der auf etwas zeigt.

Will sagen, ich kann es nicht beantworten.

Am wertvollsten finde ich ja Humor. Aber wo ordne ich den ein??

Ein hochintelligenter Algorithmus wird mich nie in Gänze kennen.

Ich selber ja auch nicht.

Ich halte das für nicht möglich.

Er kennt vielleicht mein Bewusstsein, aber das ist nur ein Teil meines Seins.

So sehe ich es.

Persönlich habe ich bislang keinerlei Angst vor irgendeiner Superintelligenz.

Davor fürchte ich mich nicht.

" Das Menschenpack fürchtet sich vor nichts mehr als den Verstand.

Vor der Dummheit sollten sie sich fürchten, wenn sie begriffen, was fürchterlich ist. " ( Goethe). Ist aus dem Buch " Die Geschwister Oppermann" von Lion Feuchtwanger.

LG.

Anna