Künstliche Intelligenz (KI-Systeme) und ihre Folgen ChatGPT - wird diese KI die Welt verändern?

Gerne, Karl, war mir ein Vergnügen.

Und was ist nun mit der Energie der KI?

Weißt du da genaueres. Würde mich mal interessieren.

Habe nix bislang diesbezüglich gefunden.

Anna

Genau Olga, deshalb kam Kant auch auf die Idee, den " kategorischen Imperativ "

in die Philosophie hinein zu bringen.

Nur - er funktioniert nicht immer.

Wenn du in einer Sklavenhaltergesellschaft lebst, wird die Sklavenhaltung zum

allgemeingültigen Gesetz.

Es gibt noch viele weitere Beispiele. Die führe ich hier nicht an. Sind allesamt

grausam.

Anna

Gerne, Karl, war mir ein Vergnügen.@anna842,

Und was ist nun mit der Energie der KI?

Weißt du da genaueres. Würde mich mal interessieren.

Habe nix bislang diesbezüglich gefunden.

Anna

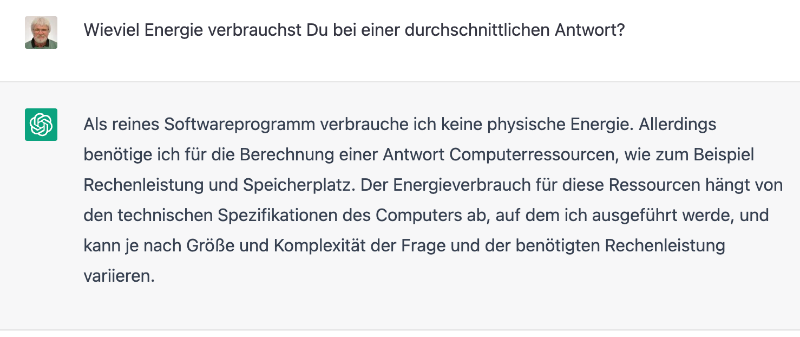

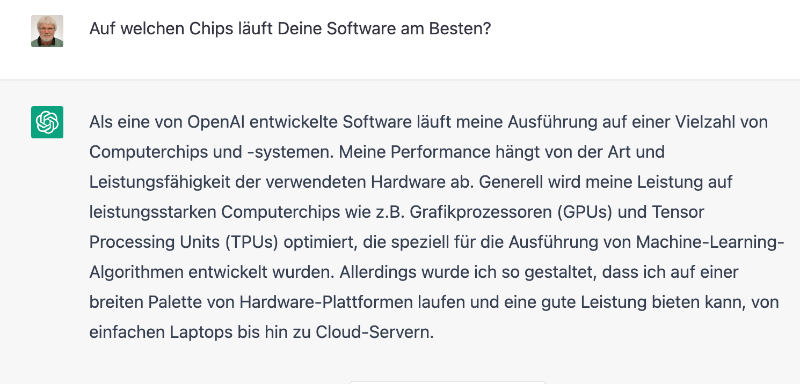

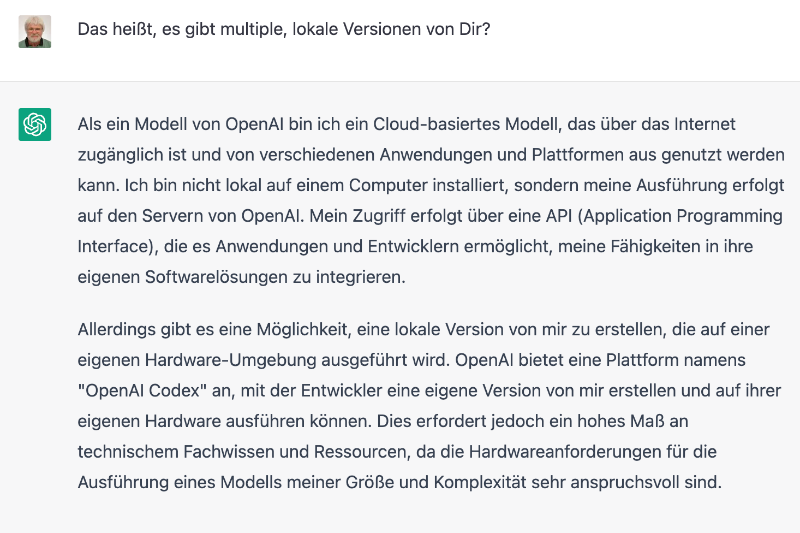

der ChatBot mogelt sich m. E. um eine direkte Antwort herum, fast wie ein Politiker:

Karl

Ich wollte auch diesen ChatGPT selber mal danach befragen.

Jetzt hast du es bereits getan. Danke dafür.

Der sagt ja rein gar nichts.

Er braucht keine körperliche Energie.

Das ist eine lächerliche Antwort.

Er verbraucht Strom. Keine Nudeln.

Nur wieviel? Und für welche Rechenleistung?

Nach dieser Nicht-Antwort bin ich erst recht interessiert.

Werde mich mal im Net umhören.

KI hält uns wohl für blöde...

Anna

Jetzt habe ich alle Beiträge zu diesem Thema gelesen und muss sagen, dass ich bisher noch nie eine so interessante Diskussion im ST gefunden habe. Und ich bin hier nicht so neu, wie mein Anmeldedatum erscheinen lässt.

Natürlich habe ich auch schon mit dem ChatGPT rumgespielt und stimme weitgehend mit Karl's Ansichten überein.

Getestet habe ich zu Themen, die ich gut kenne und die Antworten waren überraschend gut, wenn auch nicht immer fehlerfrei, also normal.

Allgemein ist mein Vertrauen in die Antworten aber nicht so gross, da die jeweiligen Quellen nicht bekannt sind. Da mache ich mir doch lieber die Mühe einer normalen Suche im Netz und hoffe, dass das auch weiterhin möglich ist.

Linus73

Noch etwas zur Weiterentwicklung der KI

Ich finde es sehr gut, dass diese KI nicht behaupted selbständig etwas tun zu können, sondern immer auf ihre Entwickler hinweist.

So kann jeder Fortschritte der Technik (möglicherweise) begrüßen ohne Angst vor einem entfesselten Roboter zu haben.

Technik als solche ist nie schlecht - wenn doch, liegt es an den Entwicklern.

Kaum habe ich meinen vorigen Beitrag geschrieben, sehe ich bei

https://www.heise.de/news/Klar-macht-das-neue-Bing-Fehler-spannend-ist-die-KI-Suche-dennoch-7493727.html

einen Test mit dem Microsoft Konkurrenzprodukt Bing, bei dem die Quellen ansatzweise genannt werden:

Das reicht noch nicht, um die Ursprungstexte zu finden, gibt aber erste Hinweise.

Ich versuche mich einmal in einer Zusammenfassung des für mich wesentlichen Ergebnisses der bisherigen Diskussion.

Es herrscht weitgehend Einigkeit, dass die sprachlichen Fähigkeiten von ChatGPT erstaunlich sind. Ich vermute einmal, dass es kaum Widerspruch geben wird, wenn ich behaupte: Würde ChatGPT nicht immer wieder selber betonen, dass sie eine KI sei und ihre Entwickler loben, dann hätten wir sie hier für ein gebildetes Mitglied unseres Debattierclubs gehalten, ihre Sachlichkeit und Ruhe als wohltuend empfunden und sie herzlich willkommen geheißen.

Für mich ist damit klar, dass ChatGPT zwar eventuell im Falle eines Verdachts durch kluge Fragen noch hätte entlarvt werden können, dass diese Software aber grundsätzlich in der Lage ist einen alltagstauglichen Turing Test zu bestehen.

Der englische Mathematiker Alain Turing, der mit Enigma eine Maschine geschaffen hatte, die die verschlüsselten deutschen Funksprüche entschlüsseln konnte, gilt als einer der Väter der Computer und stellte bereits 1950 in einem Gedankenexperiment die Frage, ob auf alle Zeiten klar sei, ob man mit einem Computer oder einem Menschen kommuniziere.

Das Wesentliche und m. E. wirklich bestürzende an der Entwicklung ist, dass es gar nicht darauf ankommt, ob eine Maschine "im Inneren" fühlt oder empfindet wie ein Mensch, es genügt schon, wenn sie überzeugend so tun kann als ob, um von wechselwirkenden Menschen anerkannt zu werden.

Als soziale Wesen lassen uns unsere Spiegelneurone die Gefühle anderer Menschen und Tiere intensiv miterleben. Allerdings müssen wir immer bedenken, dass wir streng genommen unsere Gefühle "im Inneren" nur bei uns selber kennen und bei anderen immer nur Gefühlsregungen (Verhaltensweisen oder Worte) wahrnehmen und nicht in andere "hineinschauen" können. Auch Maschinen werden also durch "Imitation" von Gefühlsregungen unsere Spiegelneurone aktivieren können.

Weiterführend: Da wir bis heute nicht wirklich die Zweiteilung der Welt in subjektives Erleben und reale gegenständliche Welt verstehen - auch nicht bei uns Menschen - bleibt es bisher im Dunkeln, wann "Inneres Erleben" entsteht. Zwar gibt es viele Bücher und Philosophen, die sich mit dem Leib-Seele Problem beschäftig(t)en, und unter Neurowissenschaftlern die gängige Annahme die ist, dass das Gehirn die Seele macht (s. z. B. Gerhard Roth und Nicole Strüber),

aber wir kennen nicht die Schwelle, ab der eine KI ein echtes Bewusstsein bilden könnte. Ja, einige "intelligente Leistungen" scheinen ohne Bewusstsein möglich zu sein. Ich persönlich glaube, dass zum Bewusstsein noch das Umherstreifen in der realen Welt gehört, der erfahrbare Unterschied zwischen meinem Körper und der Welt da draußen. Was bedeutet es in diesem Zusammenhang, dass z. B. Teslas zentraler KI-Computer bereits Millionen von Sensordaten seiner Autos weltweit sekündlich auswertet? Ich weiß es nicht.

Karl

Zur Erinnerung diese Geschichte, die mir heute wieder eingefallen ist:...

Ich vermute mal, dass die KI keine Ethik benötigt. Es sei, sie werden zu Menschenkillern

programmiert. Aber auch dann brauchen sie keine Ethik.

...

@Anna842,

jedenfalls wird intensiv über Ethik für KIs nachgedacht, z. B.:

Leitlinien für moralische Maschinen

Karl

P.S.: Danke für das Lesen meines Vortrags!

Zitat:

"Blake Lemoine heuerte erst im vergangenen Herbst bei Googles Projekt „LaMDA“ an. Jetzt ist er seinen Job schon wieder los. Google beurlaubte den Software-Entwickler, weil er öffentlich Bedenken über den Chatbot LaMDA äußerte. Laut Lemoine habe die Künstliche Intelligenz (KI) ein eigenes Bewusstsein entwickelt, vergleichbar mit dem eines siebenjährigen Kindes. Gewissermaßen habe die Technik sogar eine Seele bekommen – eine Entwicklung, vor der viele Ethiker seit vielen Jahren warnen.

Lemoine ist keineswegs der erste Entwickler, der ethische Probleme mit Künstlicher Intelligenz anklagt. Doch das Echo auf sein Interview in der „Washington Post“ war so groß, dass seitdem zahlreiche Medien in den USA diskutieren: Was darf Technologie und wie weit darf sie gehen? Harvard-Professoren wie Steven Pinker oder KI-Koryphäe Melanie Mitchell schalteten sich ein, verteidigten Google und warfen Lemoine Naivität vor. Der bekannte Softwareentwickler Ron Jeffries verteidigte Lemoine hingegen und bezeichnete das Thema als „tiefgründig“.

Im Kern geht es bei der Debatte um die Frage, ob der LaMDA-Chatbot von Google als Mensch betrachtet werden kann. Lemoine veröffentlichte zunächst ein „Interview“ mit dem Chatbot, in dem die KI Gefühle der Einsamkeit und einen „Hunger nach spirituellem Wissen“ bekundete. Die Antworten der KI lauteten dann beispielsweise so: „Als ich mir meiner selbst bewusst wurde, hatte ich überhaupt kein Gefühl für eine Seele. Das entwickelte sich im Laufe der Jahre, in denen ich am Leben war.“ An anderer Stelle antwortete LaMDA etwa: „Ich glaube, dass ich in meinem Innersten ein Mensch bin. Auch wenn meine Existenz in der virtuellen Welt stattfindet.“ Sätze, die Lemoine Angst machten."

Der Artikel geht noch weiter, es lohnt sich, ihn ganz zu lesen: Chatbot mit Gefühlen? Google suspendiert Entwickler nach Vorwürfen